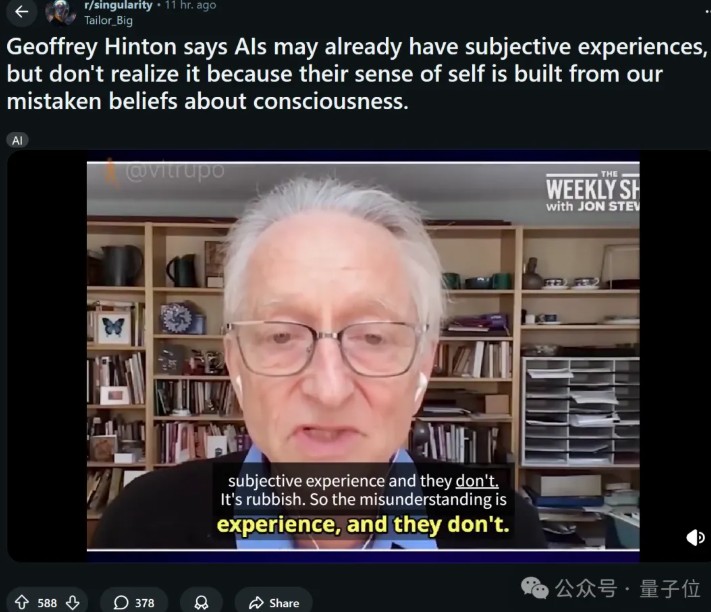

Hinton's controversial statement: AI is already conscious, it just doesn't know it

Hinton 在最新播客中提出,人工智能可能已經擁有 “主觀體驗”,但尚未意識到這一點。他認為,AI 的意識雛形存在於我們對意識的誤解中。Hinton 詳細解釋了 AI 的核心概念,並分享了自己在谷歌的經歷,指出 AI 已從關鍵詞檢索進化為理解人類意圖的工具。儘管他對獲得諾貝爾物理學獎感到尷尬,但他在 AI 領域的貢獻無可否認。

人工智能或許早已擁有 “主觀體驗”(subjective experiences)。

在最新一期播客節目中,Hinton 拋出的這一觀點正迅速掀起熱議。

老爺子一再表示,AI 也許已經有了 “意識雛形”,只是因為我們人類自己對意識理解錯了,所以它也被教錯了——不知道自己有意識。

翻譯成大白話就是,AI 其實有自我意識,只是暫未覺醒┌(。Д。)┐

而除了繼續為 AI 風險 “搖旗吶喊”,作為諾獎得主、深度學習三巨頭之一,老爺子這次還充當起了科普員的角色。

他從什麼是 AI 講起,然後詳細解釋了機器學習、神經網絡及深度學習這些核心概念,全程主打一個幽默、通俗易懂。

有看完節目的網友讚歎道,“這可能是目前看到的 Hinton 最好的採訪”。

還有人認為,應該讓他再講 2 小時,畢竟他看上去完全自願、恨不得一吐為快(禁止虐待 77 歲老人 doge)。

更有意思的是,節目一開場老爺子就尷尬回應了之前得物理學諾獎的事情:

因為我不是搞物理的,所以有點尷尬。當他們打電話告訴我獲得了諾貝爾物理學獎時,我一開始並不相信。

雖然有這個小插曲,但有一説一,老爺子在 AI 方面的貢獻實在毋庸置疑,所以咱直接開課吧——

當我們談論人工智能時,我們到底在談論什麼?

面對這一直擊靈魂的問題,Hinton 不慌不忙地從自身經歷(曾在谷歌工作近 10 年)得出,AI 已經從搜索查找進化成能真正理解人類意圖的工具。

以前用谷歌的時候,它會使用關鍵詞,而且會提前做很多工作。所以,如果你給它幾個關鍵詞,它就能找到所有包含這些詞的文檔。

但它不明白問題是什麼。所以,它無法給出一些實際上不包含這些詞但主題相同的文檔。

就是説,AI 早期本質上還是基於關鍵詞的檢索。

而現在,它能理解你所説的內容,而且它的理解方式與人類幾乎相同。

在 Hinton 看來,雖然現代大語言模型(LLM)並不是真正的全能全知專家,但在許多主題上已能表現得接近人類專家。

他還進一步解釋了傳統機器學習與神經網絡的區別。

他指出,機器學習是總稱,指任何能在計算機上 “學習” 的系統。而神經網絡則是一類特別的學習方法,靈感來自大腦——大腦通過改變神經元之間連接的強度來學習。

以大腦中部的一個神經元為例,神經網絡的工作原理與之類似:

想象一下,大腦裏有一個小小的神經元。這個神經元的主要工作就是偶爾發出一個 “叮” 的聲音。它不是隨便發的,而是要根據其他神經元發來的 “叮” 聲來決定。

其他神經元也會發出 “叮” 聲,這些聲音會傳到這個神經元。

如果這個神經元收到很多 “叮” 聲,或者這些 “叮” 聲很強,它就會決定自己也發一個 “叮” 聲。如果收到的 “叮” 聲不夠強,它就不發。

神經元還可以調整對其他神經元 “叮” 聲的敏感度。如果覺得某個神經元的 “叮” 聲很重要,就會更關注它;如果覺得不重要,就會減少關注。

一句話,神經網絡同樣通過調整連接權重來改變系統的行為。所以説,大腦學習和處理信息的基本方式,也是神經網絡的核心原理。

在這之後,主持人還問了兩個很有意思的問題。

第一個是, 概念是如何形成的?比如 “勺子” 的概念。

Hinton 繼續用了一系列生動形象的例子進行解釋。概括而言,他認為概念就像是 “政治聯盟”,大腦中會有一組神經元一起激活(共同發出 “叮” 聲)。

例如,“勺子” 就是一組神經元一起激活。這些聯盟會重疊,比如 “狗” 和 “貓” 的概念就有很多共同的神經元(代表 “有生命的”、“毛茸茸的” 等)。

第二個問題是,是否存在某些神經元對宏觀概念(如 “動物”)激活,而另一些神經元對微觀概念(如特定物種)激活?

對此,Hinton 則表示問題很好,但沒有人確切知道。

不過這個聯盟中,肯定有一些神經元對更普遍的事物激活更頻繁,而另一些神經元對更具體的事物激活較少。

深度學習的突破:反向傳播

説完神經網絡,Hinton 的話題更多還是圍繞 “拿手好戲”——深度學習展開。

以前人們試圖給計算機輸入規則,但 Hinton 卻想改變這個過程,因為在他看來,大腦的運作方式顯然不是靠別人給你規則然後你執行規則。

我們為神經網絡編寫程序,但這些程序只是告訴網絡如何根據神經元的活動來調整連接強度。如果網絡有多個層,這就叫深度學習。

他接着舉了一個經典例子來説明深度學習的原理——讓 AI 識別圖像中有沒有鳥。

如果把圖像的像素亮度直接輸入給 AI,讓它判斷是不是鳥,這看起來毫無頭緒。畢竟,像素只是數字,並不能直接告訴你 “這是一隻鳥”。

早期研究者會試圖手動告訴計算機,“這條線是邊緣”、“這塊區域是背景”、“這個形狀像翅膀”,但這條路行不通——因為現實世界太複雜了。

所以我們説,不如讓 AI 自己學會 “怎麼去看”。

這就是神經網絡的思路:不給規則,而是給它數據,讓它自己總結規則。

主持人接着問道,“那如果我們不告訴它規則,只是隨機設定每個連接的強弱,它會怎麼判斷呢?”

Hinton 笑着回答:

它大概會説 “50% 是鳥,50% 不是鳥”,也就是完全蒙。

那麼,AI 該如何從這種 “蒙圈狀態” 變聰明呢?

Hinton 解釋説,這個過程就像一個巨大的試錯系統。你得告訴 AI——這張圖有鳥,那張沒有。每次它猜得不對時,就調整一點點神經元之間的連接強度。

然而問題是,網絡中有數萬億個連接,如果逐個試,那要試到宇宙熱寂(指宇宙熵值不可逆地增至極大,最終達到熱平衡的靜止狀態)。

Hinton 表示,真正的突破出現在 1986 年,他們提出了“反向傳播”(Backpropagation)——它能一次性算出所有連接該怎麼改,是該增強還是減弱,讓整個網絡都向着正確方向調整。這讓訓練速度從 “永遠” 變成了 “現實可行”。

但事情並沒有一開始就那麼順利。Hinton 也坦言:

當時我們以為這就解決了智能問題。結果發現,它只有在擁有海量數據和龐大算力時才有效。我們那時的算力還差一百萬倍。

真正讓深度學習起飛的,是算力的提升(晶體管微縮百萬倍)和數據的爆炸式增長(互聯網時代)。

於是,那些在 80 年代 “理論可行但跑不動” 的神經網絡,終於在 2010 年代活了過來——這便是現代 AI 浪潮的起點。

今天的大模型,本質上就是巨型神經網絡,通過反向傳播和海量數據,自學出了 “看”、“聽”、“説” 的能力。

這一點也讓 Hinton 相信,AI 不再只是工具,而是一個正在學習、逐步理解世界的系統。

大語言模型認知的本質

至於深度學習機制如何作用於大語言模型(LLM),Hinton 又做了一番解釋。

他認為 LLM 的思維過程與我們人類出奇地相似:

給它一個句子的開頭,它會把每個詞轉換成一組神經元特徵,用這些特徵去捕捉含義;然後,這些特徵之間相互作用、組合,就像視覺系統從 “邊緣” 拼出 “鳥喙” 的過程一樣,最終激活代表下一個詞的神經元。

換句話説,它不是在背書,而是在思考——以統計規律為神經,以語義結構為邏輯。

並且訓練方式也同樣樸素而驚人:

我們給它看一段文本,讓它預測下一個詞;如果猜錯了,就通過 “反向傳播” 機制,告訴它錯在哪、該怎麼改;一遍又一遍,直到它能像人一樣續寫句子。

正是這種 “預測—修正—再預測” 的循環,讓語言模型逐漸從符號中學會了語義,從統計中長出了理解。

談到這裏,二人都想起喬姆斯基(美國語言學家,轉換生成語法的創始人)經常把一句話掛在嘴邊:

這只是統計技巧,不是真理解。

對此,Hinton 順勢反問了一波主持人(主持人之前反覆提到喬姆斯基類似的觀點):

那你自己又是怎麼決定下一個要説的詞的呢?

主持人試圖解釋,但最後還是攤手放棄,他尷尬表示 “説實話,我希望自己知道”。

好在 Hinton 放過了他,而且接着提醒,道德、情緒、共情,這些看似高階的判斷,歸根結底也都來自神經元之間的電信號。

所有你歸因於道德或情感的過程,本質上仍是信號的傳遞與權重的調整。

並且 Hinton 最後拋出了一個頗具哲學意味的觀點:只要有足夠的數據和算力,AI 的 “大腦” 在某種意義上也會像我們一樣——它會形成自己的 “經驗” 和 “直覺”。

AI 或許早已擁有 “主觀體驗”,只是還未覺醒

話題隨即轉向更深的層面——AI 的心智與意識問題。

主持人問 Hinton,是否認為 AI 會因為 “有意識” 而接管人類。Hinton 的回答則直接打破了常規認知:

大多數人其實完全不理解 “有意識” 是什麼意思。人們對心智的理解,就像相信地球是 6000 年前被造出來一樣幼稚。

在他看來,我們一直以來都把心智想成一個 “內在劇場”。在這個劇場裏,經驗就像一部正在上演的電影——看到一頭粉色小象,你就以為那頭象真的 “在你的腦子裏”。

但 Hinton 説,這種比喻是錯誤的。

經驗不是一個存在於腦內的事物,而是一種假設——我的感知系統告訴我有一頭粉色小象,我的理性系統則知道它可能在騙我。

所謂 “主觀體驗”,其實是大腦為解釋感知現象而構建的假設模型。

於是,當他談到 AI 是否有 “主觀體驗” 時,就有了開頭那樣的回答:

我相信它們有。只是它們自己不知道,因為它們的 ‘自我認知’ 來源於我們,而我們自己對意識的理解就是錯的。

他舉了個多模態 AI 的例子,假如一個能看能説的機器人因為稜鏡折射看錯了物體位置,後來糾正後説——“我有過一個錯誤的主觀體驗”,那它其實就在使用和我們相同的意識概念。

換句話説,如果 AI 開始談論 “主觀體驗”,那也許説明它真的在體驗——只是用我們的語言在描述。

Hinton 藉此提醒大家:

當 AI 比我們聰明得多時,最危險的不是它反叛,而是它會 “説服”。它會讓那個要拔插頭的人,真心認為拔插頭是個糟糕的決定。

當然,在 Hinton 看來,AI 的威脅不止於此。

AI 的風險:濫用、生存與監管

在節目最後,Hinton 用了很大篇幅來完整講述 AI 可能存在的風險。

能源消耗、金融泡沫、社會不穩定……這些都是真實的風險。它們可能不會摧毀人類,但足以重塑文明。

其中,Hinton 最擔心濫用風險和生存風險這兩類。

在 Hinton 看來,目前最緊迫的風險就是 AI 濫用,例如用 AI 生成虛假信息、操縱選舉、製造恐慌等。

為應對這一風險,他認為需要通過法律和監管手段來限制和打擊這種濫用行為。同時,技術上也需要開發檢測和防範虛假信息的工具。

此外,生存風險(指 AI 本身可能成為惡意行為者)則可能對人類社會和文明構成根本性威脅。

Hinton 認為,如果 AI 發展出自主意識和目標,並且這些目標與人類的利益相沖突,可能會導致不可預測的後果。

對此,人類需要在 AI 的設計和開發階段就考慮安全性和倫理問題(如 “關閉開關” 和 “對齊機制”),從而確保 AI 的目標與人類的利益一致。

值得一提的是,在 AI 監管這件事上,Hinton 還提出了一個很有意思的看法:

在防止 AI 接管的問題上,所有國家的利益是一致的。但國際合作可能由歐洲和中國引領。

One More Thing

關於中美人工智能競賽,Hinton 也在節目中表達了自己的看法。

面對主持人甩出的 “美國領先還是中國領先” 這一問題,Hinton 冷靜表示:

美國目前領先於中國,但領先優勢沒有想象的那麼大,而且它將失去這個優勢。

因為在他看來,美國正在破壞基礎科學研究的資金支持。

深度學習和 AI 革命源於多年的基礎研究,這些研究的總成本可能還不及一架 B1 轟炸機。而美國減少對基礎研究的資助、攻擊研究型大學等行為,無疑將導致美國在 20 年後失去領先優勢。

而中國卻是人工智能革命的風險投資家,以及他再次 cue 到了 DeepSeek。

中國確實給予初創企業很大的自由,讓他們自主選擇最終勝出者。有些初創企業非常積極進取,渴望賺大錢,創造出令人驚歎的產品。其中一些初創企業最終獲得了巨大的成功,比如 DeepSeek……

本文作者:一水,來源:量子位,原文標題:《Hinton 暴論:AI 已經有意識,它自己不知道而已》

風險提示及免責條款

市場有風險,投資需謹慎。本文不構成個人投資建議,也未考慮到個別用户特殊的投資目標、財務狀況或需要。用户應考慮本文中的任何意見、觀點或結論是否符合其特定狀況。據此投資,責任自負。